“风扇转速刚过每分钟2万转,硬盘就掉链子,而且多次测试结果都是这样。”即使看惯了实验室里不同工况条件下的大场面,浪潮信息服务器研发工程师张海龙对眼前的情况还是有些惊讶,“毕竟各种因素赶到一块儿的场景太罕见了”。

其实,任何事物在带来好处的同时,都要付出一定的代价。所谓鱼和熊掌兼得,不过是成千上万次再平衡之后的偶然。

比如:芯片的性能越高,产生的功耗也会随之增大,提高散热能力就成为谋求平衡的筹码;而追求极限散热,难免对硬盘等部件造成冲击,兼顾可靠性又变成新一轮平衡游戏的主题。

当然,散热和可靠性并非零和博弈,只要管控好变量,就有机会走出囚徒困境。

悬在头上的达摩克利斯剑

在千行百业数字化转型的大时代,数据中心既是驱动增长的重要引擎,也是不容忽视的“耗电怪兽”。2020年,我国数据中心用电量突破2000亿千瓦时,占用电总量比重约2.7%;预计到2030年,这一数字将突破4000亿千瓦时,占比升至3.7%。

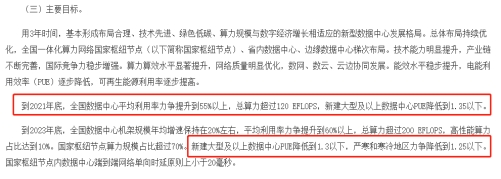

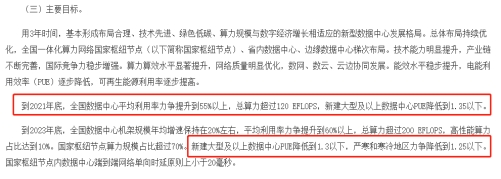

工信部近期印发《新型数据中心发展三年行动计划(2021-2023年)》,对PUE(数据中心总能耗/IT设备能耗)明确规定:到2021年底,新建大型及以上数据中心PUE降低到1.35以下,到2023年更要低于1.3。

工信部《新型数据中心发展三年行动计划(2021-2023年)》

显而易见,1.3将成为各地新建数据中心的PUE红线。但目前全国大型数据中心平均PUE为1.55,超大型数据中心平均PUE也仅为1.46。也就是说,在保有量万台服务器的数据中心,每耗费一度电,只有64.5%用于IT领域,其余35.5%则用在空调等非IT设备。

数据中心为了降低PUE,必须让能源更多向IT设备倾斜,这对服务器的供电和散热研发设计提出了更高要求。供电效率提升可降低CPU等关键部件散热量,从而减少空调等设备的使用。浪潮信息掌握了从12V到48V直流供电技术,48V直流供电预计可减少30%的能耗。

液冷是散热技术的翘楚,可以用液体取代空气作为冷媒,带走部件热量,目前常见的方式有冷板、浸没、风液混合等,已在云数据中心和边缘数据中心规模化部署,对降低PUE效果显著。但液冷技术对数据中心的机房环境要求苛刻,重新改造的成本也较高,浸没式液冷的冷却液价格更是堪比茅台。

对大多数数据中心来说,风冷才是低成本改善散热的主流方案,最“简单粗暴”的做法是提高服务器风扇转速。风扇高速转动将热量快速带出,可避免部件发热量过高影响系统稳定性。但不断加码风扇转速直至满转时,风扇与硬盘之间会形成大的漩涡,而不规则的湍流影响非常严重——服务器内的硬盘碟片磁道密度低于50nm、Ocylim低于10nm,磁头轻微振动就会造成读写性能大幅下降,甚至导致整个硬盘报废。

硬盘内部结构图

御风而行的“逍遥”苦旅

庄子在《逍遥游》中有言:“夫列子御风而行,泠然善也。旬有五日而后反。彼于致福者,未数数然也。”一场不强求结果的十五天旅行,固然悠游潇洒,但仅限于个人境界,无关万物苍生。

当张海龙及其背后的研发团队遭遇系统风扇与硬盘的激烈博弈,想在散热和可靠性的夹缝中寻求突破时,他们无法轻松自在,跨度长达一年半的“御风之旅”充满艰辛。

风冷方案历经40多年的演变,主要通过三条路径实现散热优化:一是从散热器入手,比如材料由铝变成铜、将翅片加大扩展散热面积、改良热管排布、利用富余空间补充远端散热等;二是提高风扇速度,制约点是机电控制和马达质量,主要交由几家专业的风扇厂商负责;三是在发热元件附近部署传感器,类似人体的末梢神经,一旦感知局部升温就快速投放冷量,反馈越灵敏,调控越精准。

对服务器厂商而言,风扇调控策略是其擅长的领域,研发团队要做的,恰是从系统风扇本体的声振性能为切入点,解决散热与可靠性之间的博弈。

从可能的振源到受振敏感元件之间的路径太多,需要借助对比和定量分析法,对各个因子逐一进行耦合切断,主板、存储控制卡、背板连接器等都曾上过“黑名单”。

在经历近半年的排查分析后,一个“突发奇想”的行动——索性切开机箱,把振动传递路径上的影响因子全部做解耦抽离,迫使真正的“元凶”浮出水面。机箱一切两段,切断了机械传动路径,中间用纸板把硬盘和风扇隔开,硬盘不再受风的影响,同时对风扇产生的噪声也有一定遮挡,硬盘读写功能逐渐攀高。再换不同转速的风扇及方案组合进行反复验证,最终工程师找出了“气动噪声”这个“深藏不露”的重要影响因子。

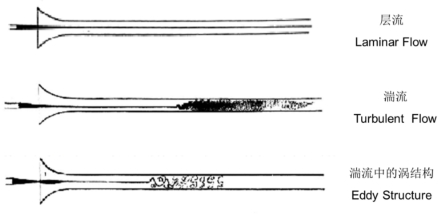

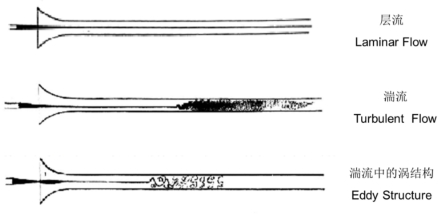

在流体力学中,这个影响因子叫做:“湍流”,也就是济南趵突泉公园康熙题字碑的“激湍”的标准名称。湍流打到风扇扇叶上,风回来得比较无序,而且有部分声音从风扇背面传到前方。要把大的空气漩涡破掉,最理想的方案肯定是将湍流转换成层流,或者在高风压条件下把大湍流切成小湍流。

2021年秋季清华大学《湍流概论》中湍流产生的介绍

PS:H.Tennekes&J.L. Lumley 曾对湍流进行过评论:尝试解决湍流问题的成功与否,强烈地取决于包括做出关键性假设的灵感。 湍流需要奔放的发明者,正如需要专业分析师那么重要。

传统服务器会采用减振垫来减缓振动,这种方法针对机械传动路径有效。同时依靠风扇后端的挡风罩切割和控制风向。但当系统风扇转速从每分钟2万转提升到3万转,机箱内部的湍流问题就愈发凸显,亟需新的机械结构在风力源头担当重任。

没有人愿意啃硬骨头,除非被逼到墙角。从层流到湍流的转体,是业界公认的难题。北大的数学大神韦东奕曾从数学模型的角度求解层流到湍流的变化,获得百万奖金。服务器的研发工程师则在应用维度作出开创性的尝试:从初期的百叶窗到最后敲定波导网,其间历经成百上千次的锤炼。研发工程师采用不同宽度、孔径的横向或纵向波导网进行多次对照试验,起始阶段效果并不理想,没有满足高可靠性的要求。但测试证明波导网的确能有效缓解振动,有助于提升通风量并形成稳定的平行风流。

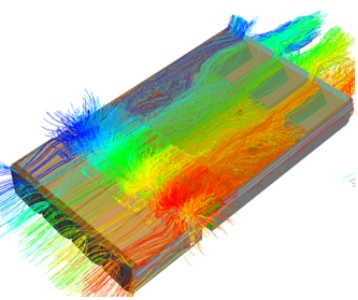

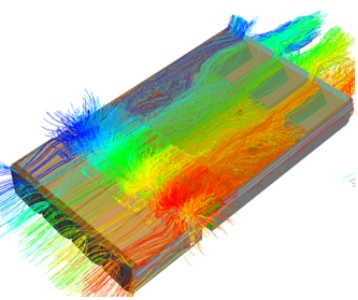

研发初期服务器内部系统流场仿真图

一个偶然的机会,研发人员受到深圳机场航站楼六边形建筑结构启发,萌生蜂巢形状波导网设计思路。综合测试后发现,六边形波导网既节省材料,通风量也适宜,同时足够坚固,对风流能有力约束,并减小湍流造成的振动,解决了风扇散热与可靠性无法兼得的难题。

波导网内部为铝制六边形蜂巢状小孔,单边厚度不足0.2mm,重量仅11克左右,可谓“薄如蝉翼”。为探求不同机型最佳波导网结构,研发工程师还针对蜂巢单元的尺寸和蜂巢板的厚度进行测试,为每一款服务器找到孔径、厚度相匹配的波导网,并对降噪需求突出的机型填加了吸音海绵。

相关数据显示,配置波导网的M6服务器散热效率大幅提升17%~22%,可让数据中心环温提升1.5~2摄氏度,节约6%~8%的能耗。此外,波导网还能减少气流对硬盘高频振动的影响,硬盘IOPS性能提升8%~10%。

“风水大师”背后的故事

波导网的横空出世,既是极限压力环境下的成果,也是浪潮信息特色研发模式的产物。

主赛道和训练赛道相结合,是孕育新技术、产品和解决方案的温床。浪潮信息在技术储备方面有良好的预研体系,结构、散热就是其中的项目。预研中的技术通常具有前瞻性,要在训练赛道上摸爬滚打;而产品研发更贴近市场需求,预研中相对成熟的技术,才有机会跻身主赛道。波导网从预研到成为M6服务器产品的标配,正是主辅赛道转化机制的受益者。

仿真与测试协同作战,是研发进程节时降本、效率提升的不二法门。从硬盘、背板到风扇前界面空间极小,风道来源异常复杂,风洞、烟雾等实测方式无法实施,针对风流、风压的流体仿真和基于各种特殊要求的机械可靠性仿真,就显得尤为重要。波导网率先尝到了甜头,为更多新技术的仿测协同树立了标杆。

打破各个资源壁,重新构建跨部门合作关系,是达成最优方案的核心路径。波导网是全新的部件,需要散热、结构、存储等不同团队持续磨合,在相互妥协的过程中探寻创新的可能。对单一指标的过分强调,有时会变成研发中最大的障碍,而每一次基于共同目标的“让步”,才是通往成功的阶梯。

优秀的研发模式是复制更多波导网传奇的基石——知道风在哪一个方向吹,就不会迷失在乱云飞渡的技术湍流里。

![]()

第八代服务器

第八代服务器 第七代服务器整机柜服务器高密度服务器

第七代服务器整机柜服务器高密度服务器 交换机

交换机 软件数据中心

软件数据中心 核心交换机

核心交换机 汇聚/接入交换机

汇聚/接入交换机 软件边缘网络

软件边缘网络 交换机

交换机 无线局域网

无线局域网 全光网络

全光网络 路由器

路由器 软件安全及运维

软件安全及运维 防火墙

防火墙 综合运维软件

综合运维软件