一、工具的下载与安装

登录BROADCOM网站上RAID控制卡的页面。

链接下面的链接:https://www.broadcom.com/products/storage/raid-controllers/megaraid-9560-8i

在”DOWNLOADS”页签中单击”Management Software and Tools”。

打开管理软件和工具列表。

下载最新版本的”StorCLI”工具。

解压后得到适用于不同操作系统的工具包。

不同操作系统下,StorCLI工具的安装方法不同,此处仅以Windows、Linux、VMware为例进行说明,其他操作系统下的安装方法请参考软件包中的”Readme”文件。

3008IMR,9361,9460,9560等raid卡适配的StorCLI工具为”storcli64″。

Windows系统下安装StorCLI工具。

将适用Windows的工具包上传到服务器操作系统任意目录(如C:\tmp)。

在Windows的运行框内输入cmd并按回车,打开命令行工具。

在命令行中输入cd 工具包所在的目录,如cd C:\tmp。

Windows下的StorCLI工具不需安装,此时可执行RAID控制卡命令。

Linux系统下安装StorCLI工具。

使用文件传输工具(例如Putty)将适用Linux的工具包上传到服务器操作系统任意目录,以/tmp为例。

在Linux命令行执行rpm -ivh /tmp/StorCLIxxx.rpm命令安装StorCLI工具。

StorCLI的安装路径为/opt/MegaRAID/storcli/,需进入该目录后执行RAID控制卡相关命令。

安装完毕后,即可执行RAID控制卡命令。

VMware系统下安装StorCLI工具。

使用文件传输工具(例如Putty)将适用VMware的工具包上传到服务器操作系统任意目录,以/tmp为例。

在VMware命令行执行esxcli software vib install -v=/tmp/vmware-xxx-storcli.vib –no-sig-check命令安装StorCLI工具,其中/tmp/vmware-xxx-storcli.vib需为StorCLI工具文件的完整路径。

StorCLI的安装路径为/opt/lsi/storcli/,需进入该目录后执行RAID控制卡相关命令。

二、查看RAID卡ID

命令功能

查看LSI SAS3108RAID卡的ID。

命令格式

storcli64 show

使用实例

# 查看LSI SAS3108RAID卡的ID。

[root@localhost ~]# ./storcli64 show

CLI Version = 007.0409.0000.0000 Nov 06, 2017

Operating system = Linux3.10.0-693.el7.x86_64

Status Code = 0

Status = Success

Description = None

Number of Controllers = 1

Host Name = localhost.localdomain

Operating System = Linux3.10.0-693.el7.x86_64

StoreLib IT Version = 07.0500.0200.0300

StoreLib IR3 Version = 15.02-0

System Overview :

===============

——————————————————————–

Ctl Model Ports PDs DGs DNOpt VDs VNOpt BBU sPR DS EHS ASOs Hlth

——————————————————————–

0 SAS3108 8 3 0 0 0 0 Msng Off – Y 3 Opt

——————————————————————–

Ctl=Controller Index|DGs=Drive groups|VDs=Virtual drives|Fld=Failed

PDs=Physical drives|DNOpt=DG NotOptimal|VNOpt=VD NotOptimal|Opt=Optimal

Msng=Missing|Dgd=Degraded|NdAtn=Need Attention|Unkwn=Unknown

sPR=Scheduled Patrol Read|DS=DimmerSwitch|EHS=Emergency Hot Spare

Y=Yes|N=No|ASOs=Advanced Software Options|BBU=Battery backup unit

Hlth=Health|Safe=Safe-mode boot

回显信息中的”Ctl”一列所对应的数字即为RAID卡的ID,如上述回显信息中表明该RAID卡的ID为”0″。

三、创建和删除RAID

命令功能

创建、删除RAID。

命令格式

命令 | 说明 |

| storcli64 /ccontroller_id add vd rlevel[0|1|5|6|10|50|60] [size=<VD1_Sz>,<VD2_Sz>,..|*all] [name=<VDNAME1>,..] drives=enclosure_id:slot_id|enclosure_id:startid–endid,enclosure_id:slot_id|enclosure_id:startid–endid [pdperarray=pdperarray] [pdcache=on|off|*default][pi] [wt|*wb|awb] [nora|*ra] [*direct|cached] [Strip=<8|16|32|64|128|256|1024>] [EmulationType=0|1|2] [Spares=[enclosure_id:slot_id|enclosure_id:startid–endid,enclosure_id:slot_id|enclosure_id:startid–endid] | 创建RAID组 |

| storcli64 /ccontroller_id/vraid_id del | 删除RAID组 |

*表示默认值。

参数说明

| 参数 | 参数说明 | 取值 |

| controller_id | RAID控制卡的ID | – |

| enclosure_id | 硬盘所在Enclosure的ID | – |

| rlevel | 要配置的RAID组级别 | level可为0、1、5、6、10、50、60,数字分别代表对应的RAID组级别。 |

| size | 要配置的RAID组容量 | 默认值为all,即所有成员盘的容量之和。 |

| name | 要配置的RAID组名称 | – |

| drives | 要加入RAID组的硬盘 | – |

| startid–endid | 硬盘的起始和结束ID | – |

| slot_id | 硬盘ID | – |

| pdperarray | 子组中的硬盘数创建RAID10、RAID50、RAID60时,需要设置此参数,创建其他级别的RAID组时,不需要设置此参数。 | – |

| pdcache | 设置RAID的成员盘的Cache状态 | on off default |

| pi | 使能数据保护 | – |

| wrcache | 设置RAID组的写Cache属性,完整的命令为wrcache=wt|wb|awb,这里”wrcache=”可省略 | wt:当硬盘子系统接收到所有传输数据后,控制器将给主机返回数据传输完成信号。 wb:控制器Cache收到所有的传输数据后,将给主机返回数据传输完成信号。 awb:在RAID控制卡无电容或电容损坏的情况下,强制使用”wb”模式。 |

| rdcache | 设置RAID组的读Cache属性,完整的命令为rdcache=ra|nora,这里”rdcache=”可省略。 | ra:从虚拟磁盘中读取所需数据时,会把后续数据同时读出放在Cache中,用户随后访问这些数据时可以直接在Cache中命中,将减少硬盘寻道操作,节省响应时间,提高了数据读取速度。 nora:RAID控制卡接收到数据读取命令时,才从虚拟磁盘读取数据,不会做预读取的操作。 |

| iopolicy | 设置RAID组的I/O策略,完整的命令为iopolicy=direct|cached,这里”iopolicy=”可省略。 说明: Cache IO的规格后续不再支持,默认为Direct IO,具体信息请查看RAID控制卡固件版本说明书。 | Direct:在读、写场景中的定义不同: 在读场景中,直接从硬盘读取数据。(”Read Policy”设置为”Read Ahead”时除外,此时读数据经过RAID控制卡的Cache处理。) 在写场景中,写数据经过RAID控制卡的Cache处理。(”Write Policy”设置为”Write Through”时除外,此时写数据不经过RAID控制卡的Cache处理,直接写入硬盘。) Cached:所有读和写均经过RAID控制卡Cache处理。仅在配置CacheCade 1.1时需要设置为此参数值,其他场景不推荐。 |

| Strip | 设置RAID组条带大小 | MR卡:64, 128, 256, 512, 1024iMR卡:只能为64单位为KB |

| EmulationType | 控制逻辑盘在OS中上报的扇区 | 0: Default,只要成员盘中有512e类型的硬盘,扇区大小显示为512e(4K)。如果成员盘类型中没有512e类型的硬盘,扇区大小显示为512n。 1: Disable,即使成员盘中是512e类型的硬盘,扇区大小也显示为512n。 2:Force,即使成员盘中没有512e类型的硬盘,扇区大小仍然显示512e(4K)。 |

| Spares | 指定RAID组的热备盘 | – |

| raid_id | 要删除的RAID组的ID | – |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

当加入到RAID组的中硬盘为多个硬盘时,需要使用逗号隔开,单个槽位硬盘表示为enclosure_id:slot_id,连续槽位的硬盘表示为:enclosure_id:startid-endid。

使用指南

无

使用实例

# 创建RAID 0。

domino:~# ./storcli64 /c0 add vd r0 size=100GB drives=252:0-3

Controller = 0

Status = Success

Description = Add VD Succeeded

# 删除RAID。

domino:~# ./storcli64 /c0/v0 del

Controller = 0

Status = Success

Description = Delete VD Succeeded

三、设置RAID组的Cache读写策略

命令功能

设置RAID组的Cache读写属性。

命令格式

storcli64 /ccontroller_id/vraid_id set wrcache=mode

参数说明

| 参数 | 参数说明 | 取值 |

| controller_id | RAID卡的ID | – |

| raid_id | 待设置的RAID的ID | – |

| mode | Cache读写模式 | wt:当硬盘子系统接收到所有传输数据后,控制器将给主机返回数据传输完成信号。 wb:控制器Cache收到所有的传输数据后,将给主机返回数据传输完成信号。 awb:在RAID卡无电容或电容损坏的情况下,强制使用”wb”模式。 |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

# 设置Cache读写模式为”wt”。

domino:~# ./storcli64 /c0/v0 set wrcache=wt

Controller = 0

Status = Success

Description = None

Details Status :

==============

—————————————

VD Property Value Status ErrCd ErrMsg

—————————————

0 wrCache WT Success 0 –

—————————————

四、设置启动项

命令功能

设置虚拟磁盘或物理硬盘为启动项。

命令格式

storcli64 /ccontroller_id/vvd_id set bootdrive=on

storcli64 /ccontroller_id/eenclosure_id/sslot_id set bootdrive=on

参数说明

参数 | 参数说明 | 取值 |

| controller_id | RAID卡的ID | – |

| vd_id | 待设置的虚拟磁盘的ID | – |

| enclosure_id | 硬盘所在Enclosure的ID | – |

| slot_id | 物理硬盘槽位编号 | – |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

# 设置VD0为启动项。

domino:~# ./storcli64 /c0/v0 set bootdrive=on

Controller = 0

Status = Success

Description = Noe

Detailed Status :

===============

----------------------------------------

VD Property Value Staus ErrCd ErrMsg

----------------------------------------

0 Boot Drive On Success 0 -

----------------------------------------

# 设置slot 7硬盘为启动项。

domino:~# ./storcli64 /c0/e252/s7 set bootdrive=on

Controller = 0

Status = Success

Description = Noe

Controller Properties :

=====================

-------------------

Ctrl_Prop Value

-------------------

BootDrive PD:252_7

-------------------

五、设置热备盘

命令功能

设置全局热备盘和局部热备盘。

命令格式

storcli64 /ccontroller_id/eenclosure_id/sslot_id add hotsparedrive [dgs=vd_id]

参数说明

参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID卡的ID | – |

| enclosure_id | 硬盘所在Enclosure的ID | – |

| slot_id | 物理硬盘槽位编号 | – |

| vd_id | 局部热备盘所属虚拟磁盘的ID | – |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

# 设置slot 3硬盘为全局热备盘。

domino:~# ./storcli64 /c0/e252/s3 add hotsparedrive

Controller = 0

Status = Success

Description = Add Hot Spare Succeeded.

# 设置slot 3硬盘为vd0的局部热备盘。

domino:~# ./storcli64 /c0/e252/s3 add hotsparedrive dgs=0

Controller = 0

Status = Success

Description = Add Hot Spare Succeeded.

六、查询和设置RAID重构

命令功能

开始、暂停、继续、停止RAID重构,并查询进度。

命令格式

storcli64 /ccontroller_id/eenclosure_id/sslot_id action rebuild

参数说明

| 参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID控制卡的ID | – |

| enclosure_id | 硬盘所在Enclosure的ID | – |

| slot_id | 物理硬盘槽位编号 | – |

| action | 要执行的操作 | start:开始重构 show:查看重构进度 pause:暂停重构 resume:继续重构 stop:停止重构 |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

# 手动开始重构。

[root@localhost ~]# ./storcli64 /c0/e70/s7 start rebuild

Controller = 0

Status = Success

Description = Start Drive Rebuild Succeeded.

# 查看硬盘当前重构状态。

[root@localhost ~]# ./storcli64 /c0/e70/s7 show rebuild

Controller = 0

Status = Success

Description = Show Drive Rebuild Status Succeeded.

—————————————————–

Drive-ID Progress% Status Estimated Time Left

—————————————————–

/c0/e70/s7 5 In progress 26 Minutes

—————————————————–

# 暂停硬盘重构进程。

[root@localhost ~]# ./storcli64 /c0/e70/s7 pause rebuild

Controller = 0

Status = Success

Description = Pause Drive Rebuild Succeeded.

# 继续重构。

[root@localhost ~]# ./storcli64 /c0/e70/s7 resume rebuild

Controller = 0

Status = Success

Description = Resume Drive Rebuild Succeeded.

# 停止重构。

[root@localhost ~]# ./storcli64 /c0/e70/s7 stop rebuild

Controller = 0

Status = Success

Description = Stop Drive Rebuild Succeeded.

七、查询和设置回拷

命令功能

开始、暂停、继续、停止回拷,并查询进度。

命令格式

| 命令 | 说明 |

| storcli64 /ccontroller_id/eenclosure_id/sslot_id start copyback target=target_enclosure_id:target_slot_id | 开始回拷。 |

| storcli64 /ccontroller_id/eenclosure_id/sslot_id action copyback | 暂停、继续、查看、停止回拷。 |

参数说明

| 参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID控制卡的ID | – |

| enclosure_id | 硬盘所在Enclosure的ID | – |

| slot_id | 物理硬盘槽位编号 | – |

| target_enclosure_id | 执行回拷的目标硬盘所在Enclosure的ID。 | – |

| target_slot_id | 执行回拷的目标物理硬盘槽位编号。 | – |

| action | 要执行的操作 | show:查看回拷进度 pause:暂停回拷 resume:继续回拷 stop:停止回拷 |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

# 手动开始回拷。

[root@localhost ~]# ./storcli64 /c0/e70/s7 start copyback target=70:3

Controller = 0

Status = Success

Description = Start Drive Copyback Succeeded.

# 查看硬盘当前回拷状态。

[root@localhost ~]# ./storcli64 /c0/e70/s3 show copyback

Controller = 0

Status = Success

Description = Show Drive Copyback Status Succeeded.

—————————————————–

Drive-ID Progress% Status Estimated Time Left

—————————————————–

/c0/e70/s3 17 In progress 16 Minutes

—————————————————–

# 暂停硬盘回拷进程。

[root@localhost ~]# ./storcli64 /c0/e70/s3 pause copyback

Controller = 0

Status = Success

Description = Pause Drive Copyback Succeeded.

# 继续回拷。

[root@localhost ~]# ./storcli64 /c0/e70/s3 resume copyback

Controller = 0

Status = Success

Description = Resume Drive Copyback Succeeded.

# 停止回拷。

[root@localhost ~]# ./storcli64 /c0/e70/s3 stop copyback

Controller = 0

Status = Success

Description = Stop Drive Copyback Succeeded.

八、查询和清除PreservedCache数据

命令功能

查询和清除PreservedCache数据。

命令格式

storcli64 /ccontroller_id show preservedcache

storcli64 /ccontroller_id/vvd_id delete preservedcache force

参数说明

参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID卡的ID | – |

| vd_id | 要操作的RAID的ID | – |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

# 查询PreservedCache。

domino:~# ./storcli64 /c0 show preservedcache

Controller = 0

Status = Success

Description = No Virtual Drive has Preserved Cache Data.

九、设置硬盘直通功能

命令功能

设置RAID卡的硬盘直通功能的使能情况,并指定直通硬盘。

命令格式

storcli64 /ccontroller_id set jbod=state

storcli64 /ccontroller_id/eenclosure_id/sslot_id set JBOD

参数说明

| 参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID卡的ID | – |

| enclosure_id | 硬盘所在Enclosure的ID | – |

| slot_id | 物理硬盘槽位编号 | – |

| state | RAID卡JBOD功能的使能情况 | on off |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

# 使能RAID卡的硬盘直通功能,并设置slot 7硬盘为直通盘。

domino:~# ./storcli64 /c0 set jbod=on

Controller = 0

Status = Success

Description = None

Controller Properties :

=====================

—————-

Ctrl_Prop Value

—————-

JBOD ON

—————-

domino:~# ./storcli64 /c0/e252/s7 set JBOD

Controller = 0

Status = Success

Description = Set Drive JBOD Succeeded.

十、设置硬盘状态

命令功能

强制设置硬盘状态。

命令格式

storcli64 /ccontroller_id/eenclosure_id/sslot_id set state

参数说明

| 参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID卡的ID | – |

| enclosure_id | 硬盘所在Enclosure的ID | – |

| slot_id | 物理硬盘槽位编号 | – |

| state | 要设置的硬盘状态 | online:将硬盘上线。当Degraded状态的RAID组中有成员盘是offline状态时,可通过该参数,将RAID组中offline的成员盘重新加入RAID组,使offline状态的成员盘重新变成online状态。 offline:将硬盘离线。使用该参数,会将目标硬盘脱离RAID组,导致具有冗余功能的RAID组降级(如果离线的硬盘数量超过RAID组最大故障硬盘数量,RAID组也会变成offline状态);没有冗余功能的RAID组会直接变成Failed(故障)状态。 jbod:通过该参数可以将硬盘设置为直通硬盘。 good: ubad状态的硬盘,使用该参数可将硬盘设为ugood(foreign)状态,此时可选择导入或清除外来配置; JBOD状态的硬盘,使用该参数可将硬盘设为ugood状态,ugood状态的硬盘可用于创建RAID或者热备盘。 |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

# 将”Unconfigured Bad”状态下的slot 1硬盘设置为”Unconfigured Good”状态。

domino:~# ./storcli64 /c0/e0/s1 set good force

Controller = 0

Status = Success

Description = Set Drive Good Succeeded.

# 设置slot 7硬盘为直通盘。

domino:~# ./storcli64 /c0/e252/s7 set JBOD

Controller = 0

Status = Success

Description = Set Drive JBOD Succeeded.

![]() 十一、设置硬盘定位指示灯状态

十一、设置硬盘定位指示灯状态

命令功能

点亮和熄灭指定硬盘的定位指示灯。

命令格式

storcli64 /ccontroller_id/eenclosure_id/sslot_id action locate

参数说明

| 参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID卡的ID | – |

| enclosure_id | 硬盘所在Enclosure的ID | 可以为all,表示点亮所有Enclosure下属的硬盘的定位指示灯。 |

| slot_id | 物理硬盘槽位编号 | 可以为all,表示点亮Enclosure下属的所有硬盘的定位指示灯。 |

| action | 要执行的操作 | start:点亮硬盘的定位指示灯。 stop:熄灭硬盘的定位指示灯。 |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

# 点亮slot 7硬盘的定位指示灯。

domino:~# ./storcli64 /c0/e252/s7 start locate

Controller = 0

Status = Success

Description = Start Drive Locate Succeeded.

十二、查询RAID卡/RAID组/物理硬盘信息

命令功能

查询RAID卡、虚拟磁盘、物理硬盘的详细信息。

命令格式

storcli64 /ccontroller_id show

storcli64 /ccontroller_id/eenclosure_id/sslot_id show all

storcli64 /ccontroller_id/vvd_id show all

参数说明

参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID卡的ID | 可以将该参数设置为all,表示查询该工具可管理的所有控制器的ID |

| enclosure_id | 硬盘所在Enclosure的ID | 可以将该参数设置为all,表示查询该工具可管理的所有控制器连接的硬盘背板的ID |

| slot_id | 物理硬盘槽位编号 | 可以将该参数设置为all,表示查询所有硬盘的ID |

| vd_id | 虚拟磁盘ID | 可以将该参数设置为all,表示查询所有虚拟磁盘的ID |

使用指南

回显中主要字段的含义如表8-76所示。

表8-76 回显说明

| 命令格式 | 字段 | 含义 | 举例 |

| storcli64 /ccontroller_id show | Product Name | RAID卡的型号 | sas3108 |

| FW Version | RAID卡的FW版本 | 4.660.00-8140 | |

| Driver Name | RAID卡的驱动名称 | megaraid_sas | |

| Driver Version | RAID卡的驱动版本 | 06.811.02.00-rh3 | |

| Current Personality | RAID卡的工作模式 | RAID-Mode | |

| storcli64 /ccontroller_id/eenclosure_id/sslot_id show all | SN | 物理硬盘的序列号 | PHWL517601YR800RGN |

| Manufacturer Id | 物理硬盘的供应商ID | ATA | |

| Model Number | 物理硬盘的模块序号 | INTEL SSDSC2BB800G4 | |

| Firmware Revision | 物理硬盘的FW版本 | D2010370 | |

| Raw size | 物理硬盘的容量 | 745.211 GB [0x5d26ceb0 Sectors] | |

| Logical Sector Size | 物理硬盘逻辑分区大小 | 512B | |

| Physical Sector Size | 物理扇区大小 | 4 KB | |

| storcli64 /ccontroller_id/vvd_id show all | TYPE | RAID组的级别 | RAID1 |

| State | RAID组的状态 | Optl | |

| Access | RAID组数据的访问策略 | RW | |

| Cache | RAID组当前的读写策略与IO Policy | RWTD | |

| Size | RAID组的大小 | 100.0 GB | |

| PDs for VD0 | RAID组下的物理硬盘 | – | |

| Strip Size | RAID组的条带大小 | 256KB | |

| Write Cache(initial setting) | RAID组Cache的写策略 | Write Through | |

| Disk Cache Policy | RAID组成员盘的Cache策略 | Disk’s Default |

使用实例

#查询RAID卡的详细信息。

[root@localhost ~]# ./storcli64 /c0 show

Generating detailed summary of the adapter, it may take a while to complete.

CLI Version = 007.0409.0000.0000 Nov 06, 2017

Operating system = Linux3.10.0-514.el7.x86_64

Controller = 0

Status = Success

Description = None

Product Name = SAS3108

Serial Number =

SAS Address = 50030130f0900000

PCI Address = 00:01:00:00

System Time = 07/07/2018 22:06:42

Mfg. Date = 00/00/00

Controller Time = 07/07/2018 14:06:41

FW Package Build = 24.16.0-0093

BIOS Version = 6.32.02.0_4.17.08.00_0x06150500

FW Version = 4.660.00-8140

Driver Name = megaraid_sas

Driver Version = 06.811.02.00-rh3

Current Personality = RAID-Mode

Vendor Id = 0x1000

Device Id = 0x5D

SubVendor Id = 0x19E5

SubDevice Id = 0xD207

Host Interface = PCI-E

Device Interface = SAS-12G

Bus Number = 1

Device Number = 0

Function Number = 0

Drive Groups = 1

TOPOLOGY :

========

-----------------------------------------------------------------------------

DG Arr Row EID:Slot DID Type State BT Size PDC PI SED DS3 FSpace TR

-----------------------------------------------------------------------------

0 - - - - RAID1 Optl N 744.125 GB dflt N N none N N

0 0 - - - RAID1 Optl N 744.125 GB dflt N N none N N

0 0 0 252:1 18 DRIVE Onln N 744.125 GB dflt N N none - N

0 0 1 252:0 48 DRIVE Onln N 744.125 GB dflt N N none - N

-----------------------------------------------------------------------------

DG=Disk Group Index|Arr=Array Index|Row=Row Index|EID=Enclosure Device ID

DID=Device ID|Type=Drive Type|Onln=Online|Rbld=Rebuild|Dgrd=Degraded

Pdgd=Partially degraded|Offln=Offline|BT=Background Task Active

PDC=PD Cache|PI=Protection Info|SED=Self Encrypting Drive|Frgn=Foreign

DS3=Dimmer Switch 3|dflt=Default|Msng=Missing|FSpace=Free Space Present

TR=Transport Ready

Virtual Drives = 1

VD LIST :

=======

---------------------------------------------------------------

DG/VD TYPE State Access Consist Cache Cac sCC Size Name

---------------------------------------------------------------

0/0 RAID1 Optl RW Yes RWBD - ON 744.125 GB

---------------------------------------------------------------

Cac=CacheCade|Rec=Recovery|OfLn=OffLine|Pdgd=Partially Degraded|Dgrd=Degraded

Optl=Optimal|RO=Read Only|RW=Read Write|HD=Hidden|TRANS=TransportReady|B=Blocked|

Consist=Consistent|R=Read Ahead Always|NR=No Read Ahead|WB=WriteBack|

AWB=Always WriteBack|WT=WriteThrough|C=Cached IO|D=Direct IO|sCC=Scheduled

Check Consistency

Physical Drives = 6

PD LIST :

=======

---------------------------------------------------------------------------------

EID:Slt DID State DG Size Intf Med SED PI SeSz Model Sp Type

---------------------------------------------------------------------------------

252:0 48 Onln 0 744.125 GB SATA SSD N N 512B INTEL SSDSC2BB800G4 U -

252:1 18 Onln 0 744.125 GB SATA SSD N N 512B INTEL SSDSC2BB800G4 U -

252:2 19 UGood - 744.125 GB SATA SSD N N 512B INTEL SSDSC2BA800G4 U -

252:3 20 UGood - 744.125 GB SATA SSD N N 512B INTEL SSDSC2BA800G4 U -

252:4 49 UGood - 744.125 GB SATA SSD N N 512B INTEL SSDSC2BB800G4 U -

252:5 47 UGood - 744.125 GB SATA SSD N N 512B INTEL SSDSC2BB800G4 U -

---------------------------------------------------------------------------------

EID-Enclosure Device ID|Slt-Slot No.|DID-Device ID|DG-DriveGroup

DHS-Dedicated Hot Spare|UGood-Unconfigured Good|GHS-Global Hotspare

UBad-Unconfigured Bad|Onln-Online|Offln-Offline|Intf-Interface

Med-Media Type|SED-Self Encryptive Drive|PI-Protection Info

SeSz-Sector Size|Sp-Spun|U-Up|D-Down/PowerSave|T-Transition|F-Foreign

UGUnsp-Unsupported|UGShld-UnConfigured shielded|HSPShld-Hotspare shielded

CFShld-Configured shielded|Cpybck-CopyBack|CBShld-Copyback Shielded

Cachevault_Info :

===============

------------------------------------

Model State Temp Mode MfgDate

------------------------------------

CVPM02 Optimal 28C - 2016/11/04

------------------------------------

#查询slot0的物理硬盘的信息。

[root@localhost ~]# ./storcli64 /c0/e252/s0 show all

CLI Version = 007.0409.0000.0000 Nov 06, 2017

Operating system = Linux3.10.0-514.el7.x86_64

Controller = 0

Status = Success

Description = Show Drive Information Succeeded.

Drive /c0/e252/s0 :

=================

---------------------------------------------------------------------------------

EID:Slt DID State DG Size Intf Med SED PI SeSz Model Sp Type

---------------------------------------------------------------------------------

252:0 48 Onln 0 744.125 GB SATA SSD N N 512B INTEL SSDSC2BB800G4 U -

---------------------------------------------------------------------------------

EID-Enclosure Device ID|Slt-Slot No.|DID-Device ID|DG-DriveGroup

DHS-Dedicated Hot Spare|UGood-Unconfigured Good|GHS-Global Hotspare

UBad-Unconfigured Bad|Onln-Online|Offln-Offline|Intf-Interface

Med-Media Type|SED-Self Encryptive Drive|PI-Protection Info

SeSz-Sector Size|Sp-Spun|U-Up|D-Down/PowerSave|T-Transition|F-Foreign

UGUnsp-Unsupported|UGShld-UnConfigured shielded|HSPShld-Hotspare shielded

CFShld-Configured shielded|Cpybck-CopyBack|CBShld-Copyback Shielded

Drive /c0/e252/s0 - Detailed Information :

========================================

Drive /c0/e252/s0 State :

=======================

Shield Counter = 0

Media Error Count = 0

Other Error Count = 0

Drive Temperature = 20C (68.00 F)

Predictive Failure Count = 0

S.M.A.R.T ____alert flagged by drive = No

Drive /c0/e252/s0 Device attributes :

===================================

SN = PHWL517601YR800RGN

Manufacturer Id = ATA

Model Number = INTEL SSDSC2BB800G4

NAND Vendor = NA

WWN = 55cd2e404c533246

Firmware Revision = D2010370

Raw size = 745.211 GB [0x5d26ceb0 Sectors]

Coerced size = 744.125 GB [0x5d040800 Sectors]

Non Coerced size = 744.711 GB [0x5d16ceb0 Sectors]

Device Speed = 6.0Gb/s

Link Speed = 6.0Gb/s

NCQ setting = Enabled

Write cache = N/A

Logical Sector Size = 512B

Physical Sector Size = 4 KB

Connector Name = Port A x1

Drive /c0/e252/s0 Policies/Settings :

===================================

Drive position = DriveGroup:0, Span:0, Row:1

Enclosure position = 1

Connected Port Number = 0(path0)

Sequence Number = 2

Commissioned Spare = No

Emergency Spare = No

Last Predictive Failure Event Sequence Number = 0

Successful diagnostics completion on = N/A

SED Capable = No

SED Enabled = No

Secured = No

Cryptographic Erase Capable = No

Locked = No

Needs EKM Attention = No

PI Eligible = No

Certified = No

Wide Port Capable = No

Port Information :

================

-----------------------------------------

Port Status Linkspeed SAS address

-----------------------------------------

0 Active 6.0Gb/s 0x4433221100000000

-----------------------------------------

Inquiry Data =

40 00 ff 3f 37 c8 10 00 00 00 00 00 3f 00 00 00

00 00 00 00 48 50 4c 57 31 35 36 37 31 30 52 59

30 38 52 30 4e 47 20 20 00 00 00 00 00 00 32 44

31 30 33 30 30 37 4e 49 45 54 20 4c 53 53 53 44

32 43 42 42 30 38 47 30 20 34 20 20 20 20 20 20

20 20 20 20 20 20 20 20 20 20 20 20 20 20 01 80

00 40 00 2f 00 40 00 00 00 00 07 00 ff 3f 10 00

3f 00 10 fc fb 00 01 bf ff ff ff 0f 00 00 07 00

# 查询VD 0的信息。

[root@rhel6u5 ~]# /opt/MegaRAID/storcli/storcli64 /c0/v0 show all

Controller = 0

Status = Success

Description = None

/c0/v0 :

======

---------------------------------------------------------

DG/VD TYPE State Access Consist Cache sCC Size Name

---------------------------------------------------------

1/0 RAID1 Optl RW Yes RWTD - 1.089 TB

---------------------------------------------------------

Cac=CacheCade|Rec=Recovery|OfLn=OffLine|Pdgd=Partially Degraded|dgrd=Degraded

Optl=Optimal|RO=Read Only|RW=Read Write|B=Blocked|Consist=Consistent|

R=Read Ahead Always|NR=No Read Ahead|WB=WriteBack|

AWB=Always WriteBack|WT=WriteThrough|C=Cached IO|D=Direct IO|sCC=Scheduled

Check Consistency

PDs for VD 0 :

============

-----------------------------------------------------------------------

EID:Slt DID State DG Size Intf Med SED PI SeSz Model Sp

-----------------------------------------------------------------------

25:22 14 Onln 1 1.089 TB SAS HDD N N 512B ST1200MM0007 U

25:23 26 Onln 1 1.089 TB SAS HDD N N 512B ST1200MM0007 U

-----------------------------------------------------------------------

EID-Enclosure Device ID|Slt-Slot No.|DID-Device ID|DG-DriveGroup

DHS-Dedicated Hot Spare|UGood-Unconfigured Good|GHS-Global Hotspare

UBad-Unconfigured Bad|Onln-Online|Offln-Offline|Intf-Interface

Med-Media Type|SED-Self Encryptive Drive|PI-Protection Info

SeSz-Sector Size|Sp-Spun|U-Up|D-Down|T-Transition|F-Foreign

UGUnsp-Unsupported|UGShld-UnConfigured shielded|HSPShld-Hotspare shielded

CFShld-Configured shielded

VD0 Properties :

==============

Strip Size = 256 KB

Number of Blocks = 2341795840

VD has Emulated PD = No

Span Depth = 1

Number of Drives Per Span = 2

Write Cache(initial setting) = WriteThrough

Disk Cache Policy = Disk's Default

Encryption = None

Data Protection = Disabled

Active Operations = None

Exposed to OS = Yes

Creation Date = 04-01-2018

Creation Time = 12:38:35 PM

Emulation type = None

十三、恢复Frn-Bad状态的硬盘(谨慎操作)

命令功能

将Frn-Bad状态的RAID成员盘恢复为Online状态。

命令格式

storcli64 /ccontroller_id/eenclosure_id/sslot_id set good

storcli64 /ccontroller_id/fall import

storcli64 /ccontroller_id/eenclosure_id/sslot_id start rebuild

参数说明

参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID卡的ID | – |

| enclosure_id | 硬盘所在Enclosure的ID | – |

| slot_id | 成员盘的物理硬盘槽位编号 | – |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

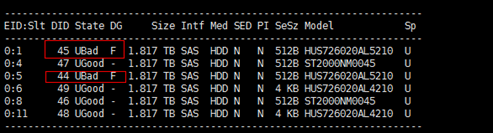

如图8-225所示,slot 1和slot 5硬盘的状态为”UBad F”,在OS下可通过以下步骤将硬盘状态恢复为”online”。

图8-225 硬盘状态

1、先把slot 1和slot 5的硬盘状态设置为UGood。

domino:~# ./storcli64 /c0/e0/s1,5 set good

Controller = 0

Status = Success

Description = Set Drive Good Succeeded.

2、导入外部配置。

domino:~# ./storcli64 /c0/fall import

Controller = 0

Status = Success

Description = Successfully imported foreign configuration

3、导入外部配置后,如果需要重构RAID(以slot1为例),则执行以下命令。

domino:~# ./storcli64 /c0/e0/s1 start rebuild

Controller = 0

Status = Success

Description = Start Drive Rebuild Succeeded.

十四、查询超级电容的相关信息

命令功能

查询超级电容的名称及TFM Flash卡缓存容量的大小等信息。

命令格式

storcli64 /ccontroller_id/cv show all

参数说明

| 参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID卡的ID | 可以为all,表示所有控制器。 |

查看RAID卡ID的方法请参见查看RAID卡ID。

使用实例

#查询超级电容的相关信息。

[root@localhost ~]# ./storcli64 /c0/cv show all

CLI Version = 007.0409.0000.0000 Nov 06, 2017

Operating system = Linux3.10.0-514.el7.x86_64

Controller = 0

Status = Success

Description = None

Cachevault_Info :

===============

——————–

Property Value

——————–

Type CVPM02

Temperature 28 C

State Optimal

——————–

Firmware_Status :

===============

—————————————

Property Value

—————————————

Replacement required No

No space to cache offload No

Module microcode update required No

—————————————

GasGaugeStatus :

==============

——————————

Property Value

——————————

Pack Energy 294 J

Capacitance 108 %

Remaining Reserve Space 0

——————————

Design_Info :

===========

————————————

Property Value

————————————

Date of Manufacture 04/11/2016

Serial Number 22417

Manufacture Name LSI

Design Capacity 288 J

Device Name CVPM02

tmmFru N/A

CacheVault Flash Size 8.0 GB

tmmBatversionNo 0x05

tmmSerialNo 0xee7d

tmm Date of Manufacture 09/12/2016

tmmPcbAssmNo 022544412A

tmmPCBversionNo 0x03

tmmBatPackAssmNo 49571-13A

scapBatversionNo 0x00

scapSerialNo 0x5791

scap Date of Manufacture 04/11/2016

scapPcbAssmNo 1700134483

scapPCBversionNo A

scapBatPackAssmNo 49571-13A

Module Version 6635-02A

————————————

Properties :

==========

————————————————————–

Property Value

————————————————————–

Auto Learn Period 27d (2412000 seconds)

Next Learn time 2018/08/03 17:48:38 (586633718 seconds)

Learn Delay Interval 0 hour(s)

Auto-Learn Mode Transparent

————————————————————–

上述回显信息中,”Device Name CVPM02″表示超级电容的名称为 “CVPM02″,”CacheVault Flash Size 8.0GB”表示TFM Flash卡缓存容量为”8.0GB”。

当回显信息的”State”显示为”FAILED”时,需要更换超级电容。

十五、手动重构RAID

命令功能

手动重构RAID组。

命令格式

storcli64 /ccontroller_id/eenclosure_id/sslot_id insert dg=DG array=Arr row=Row

storcli64 /ccontroller_id/eenclosure_id/sslot_id start rebuild

参数说明

参数 | 参数说明 | 取值 |

| controller_id | 硬盘所在RAID卡的ID | – |

| enclosure_id | 硬盘所在Enclosure的ID | – |

| slot_id | 要加入Array的物理硬盘槽位编号 | – |

| DG | 硬盘发生故障的DG的ID | – |

| Arr | 硬盘发生故障的Array的ID | – |

| Row | 硬盘发生故障的Array的row number | – |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

重构RAID分3个步骤进行:

1.通过./storcli64 /c0 show 命令,查询故障硬盘的DG、Arr和Row所对应的数字。

2.通过storcli64 /ccontroller_id/eenclosure_id/sslot_id insert dg=DG array=Arr row=Row 命令,将硬盘加入RAID组。

3.执行storcli64 /ccontroller_id/eenclosure_id/sslot_id start rebuild命令,手动重构RAID。

使用实例

# 将硬盘加入RAID组。

[root@localhost ~]# storcli64 /c0/e252/s1 insert dg=0 array=0 row=0

CLI Version = 007.0504.0000.0000 Nov 22, 2017

Operating system = Linux 3.10.0-693.el7.x86_64

Controller = 0

Status = Success

Description = Insert Drive Succeeded.

# 手动重构RAID。

[root@localhost ~]# storcli64 /c0/e252/s1 start rebuild

CLI Version = 007.0504.0000.0000 Nov 22, 2017

Operating system = Linux 3.10.0-693.el7.x86_64

Controller = 0

Status = Success

Description = Start Drive Rebuild Succeeded.

十六、设置自动恢复热备盘状态

命令功能

对热备盘进行插拔后,热备盘状态变为Ubad,设置自动恢复热备盘状态后,热备盘状态会自动恢复成hotspare,若不设置自动恢复热备盘状态,则需要手动恢复热备盘状态。

命令格式

storcli64 /ccontroller_id set restorehotspare=on

storcli64 /ccontroller_id set restorehotspare=off

参数说明

参数 | 参数说明 | 取值 |

| controller_id | RAID卡的ID | – |

查看RAID卡ID的方法请参见查看RAID卡ID。

使用指南

无

使用实例

# 启用热备盘状态自动恢复

# 关闭热备盘状态自动恢复

十七、查看/导入/清除外部配置

命令功能

指导用户查看、导入或者清除RAID卡的外部配置。

命令格式

storcli64 /ccontroller_id/fall import preview

storcli64 /ccontroller_id/fall import

storcli64 /ccontroller_id/fall delete

参数说明

参数 | 参数说明 | 取值 |

| controller_id | RAID卡的ID | – |

查看RAID卡ID的方法请参见查看RAID卡ID。

使用指南

无

使用实例

# 查看RAID卡的外部配置。

[root@localhost ~]# ./storcli64 /c0/fall import preview

CLI Version = 007.0504.0000.0000 Nov 22, 2017

Operating system = Linux 3.10.0-957.el7.x86_64

Controller = 0

Status = Success

Description = Operation on foreign configuration Succeeded

FOREIGN PREVIEW :

===============

DG=Disk Group Index|Arr=Array Index|Row=Row Index|EID=Enclosure Device ID

DID=Device ID|Type=Drive Type|Onln=Online|Rbld=Rebuild|Dgrd=Degraded

Pdgd=Partially degraded|Offln=Offline|BT=Background Task Active

PDC=PD Cache|PI=Protection Info|SED=Self Encrypting Drive|Frgn=Foreign

DS3=Dimmer Switch 3|dflt=Default|Msng=Missing|FSpace=Free Space Present

TR=Transport Ready

Total foreign drive groups = 0

# 删除RAID卡的外部配置。

[root@localhost ~]# ./storcli64 /c0/fall delete

CLI Version = 007.0504.0000.0000 Nov 22, 2017

Operating system = Linux 3.10.0-957.el7.x86_64

Controller = 0

Status = Success

Description = Successfully deleted foreign configuration

十八、设置RAID组的Cache读写策略

命令功能

设置RAID组的Cache读写属性。

命令格式

storcli64 /ccontroller_id/vraid_id set wrcache=mode

参数说明

| 参数 | 参数说明 | 取值 |

| controller_id | RAID卡的ID | – |

| raid_id | 待设置的RAID的ID | – |

| mode | Cache读写模式 | wt:当硬盘子系统接收到所有传输数据后,控制器将给主机返回数据传输完成信号。 wb:控制器Cache收到所有的传输数据后,将给主机返回数据传输完成信号。 awb:在RAID卡无电容或电容损坏的情况下,强制使用”wb”模式。 |

以上涉及的各个ID的查询方法请参见查询RAID卡/RAID组/物理硬盘信息。

使用指南

无

使用实例

# 设置Cache读写模式为”wt”。

domino:~# ./storcli64 /c0/v0 set wrcache=wt

Controller = 0

Status = Success

Description = None

Details Status :

==============

—————————————

VD Property Value Status ErrCd ErrMsg

—————————————

0 wrCache WT Success 0 –

—————————————