完整攻略免踩坑!元脑CPU推理服务器大模型部署实战指南来了

2025年07月16日

分享

随着大模型智能生产力加速渗透到医疗、教育、金融等领域,各行各业纷纷通过本地部署DeepSeek-R1 32B、QwQ-32B等大模型来提升业务能力,激发行业创新发展。但其部署和运行通常需要专用的GPU服务器,要在中小企业的CPU服务器上运行,面临计算框架选择、环境适配、性能调优等多重考验。

本文首次公布CPU服务器部署大模型详细教程,企业可在1小时内基于元脑CPU推理服务器NF8260G7和NF8480G7快速部署并运行DeepSeek-R1和Qwen3、QwQ等大模型。CPU服务器部署大模型的软硬协同优化方案,首次投入可节约80%以上建设成本,且运行功耗更低,运维更便捷,有效降低客户TCO,为企业提供了一种更经济高效的算力选择。

CPU运行大模型推理的需求:面临框架、环境等多重考验

大模型推理技术快速发展,实现CPU轻量化模型推理是业界创新方案,但一般企业要在CPU服务器实现大模型部署,往往面临诸多难题:

缺少适配框架:模型部署需要推理框架支持,推理框架对CPU架构优化有限,存在计算资源利用率低、并行策略低效等问题,难以释放CPU全量计算潜力;

计算环境复杂:需精准匹配指令集加速库(如AMX/AVX-512)、内存管理工具及量化依赖包,环境配置容错率低高;

无部署流程指导:缺失针对CPU拓扑结构的部署最佳实践,包括CPU内存绑定、线程分配等关键参数调优指南,导致部署效率低下。

浪潮信息针对CPU推理服务器的大模型部署场景进行了全方位优化,包括硬件架构设计、软件调优和量化算法创新,并基于实践经验总结出包含环境配置、模型部署和应用接入和性能调优等关键环节的高效四步部署指南,企业可在1小时内完成DeepSeek-R1 32B、QwQ-32B私有化部署,实现高性能、低成本的大模型落地。实测数据显示,该方案基于元脑CPU推理服务器NF8260G7和NF8480G7部署大模型,支持单用户超过20 tokens/s的推理性能,并能同时处理20个并发用户请求,实现高性能、低成本的大模型落地。

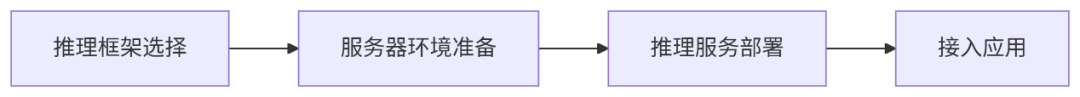

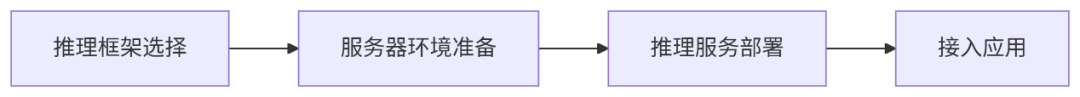

基于CPU推理服务器实现大模型部署的步骤

基于CPU推理服务器实现大模型部署的步骤

CPU服务器本地快速部署DeepSeekR1-32B大模型指南

■ 第一步 推理框架选择

在大模型私有部署的企业级应用场景中,推理框架的选择尤为关键。当前,vLLM和SGLang凭借卓越的性能、强大的并发处理能力和良好的可扩展性,已成为业界广泛认可的企业级开源首选方案。

针对企业级CPU推理的应用需求,元脑服务器选择vLLM推理框架,不仅拥有卓越的推理性能,还支持更丰富的模型推理数值精度,除常见的FP16和BF16之外,还兼容AWQ、GPTQ等多种4bit和8bit主流量化算法,灵活适配不同规模和精度要求的模型,在保证推理效率的同时,有效降低部署所需的硬件资源。

■ 第二步 服务器环境准备

为精准匹配指令集加速库(如AMX/AVX-512)、内存管理工具及量化环境,在推理服务部署前,需要安装服务器操作系统、Docker驱动等基础软件,并将CPU状态提前进行设置,以获取器更好的推理计算性能。

■ 第三步 推理服务部署

针对大多数用户,可以通过开源社区的OpenStation平台在CPU服务器部署大模型,操作简便,内置性能优化方案,省时省力;而对于有定制化、安全或性能有特殊需求的用户,也可选择Docker手动部署。

>> 基于OpenStation自动化部署

○ 一站式大模型推理服务部署和管理平台,兼容标准 OpenAI API 接口,内置vLLM推理引擎

○ 首先在“模型库”中选择需要的DeepSeek模型进行下载

○ 进入“模型服务”,点击“新增部署”,按照引导选择模型来源和部署节点,CPU节点平台会自动推荐vLLM(CPU-only)作为推理引擎

○ 提交部署,部署完成后可在“模型服务”页面查看

>> 基于Docker手动部署

○ 把定制优化的vLLM打包成Docker镜像,存储于阿里云easyds Docker镜像仓库

○ 部署32B模型时,建议使用AWQ 4bit量化版本,模型权重从Huggingface或modelscope上下载

○ 使用vLLM镜像创建容器,并把模型权重所在的路径挂载到容器中

○ 容器启动后,在容器中启动vllm服务

■ 第四步 应用接入

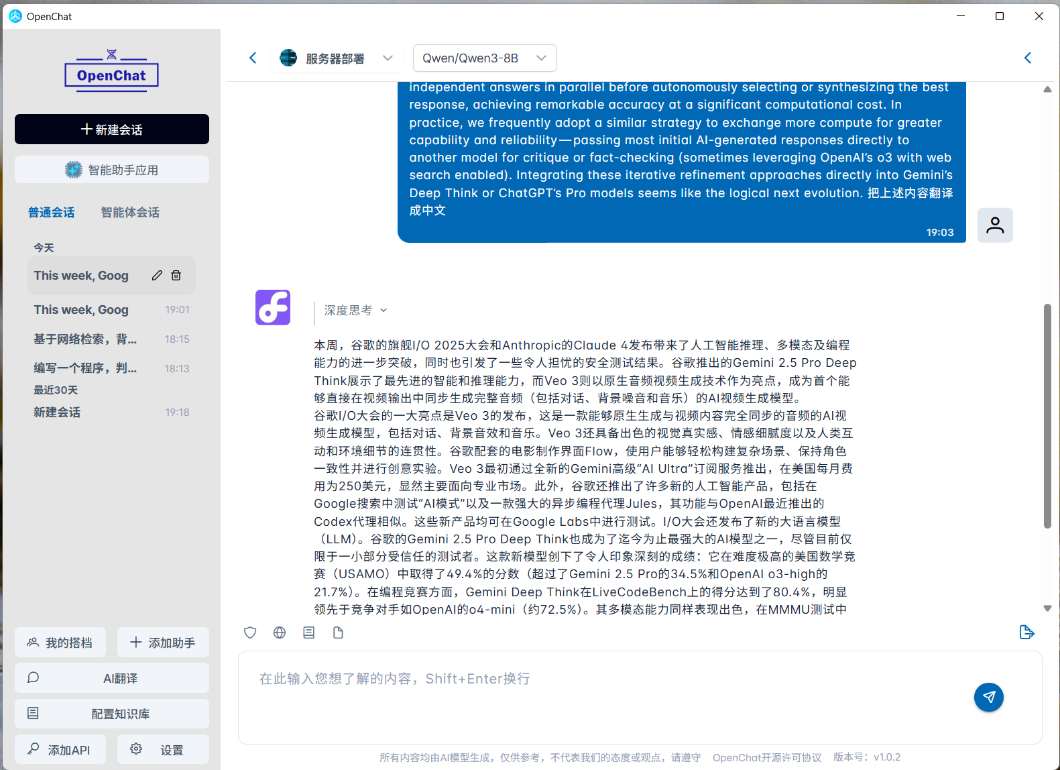

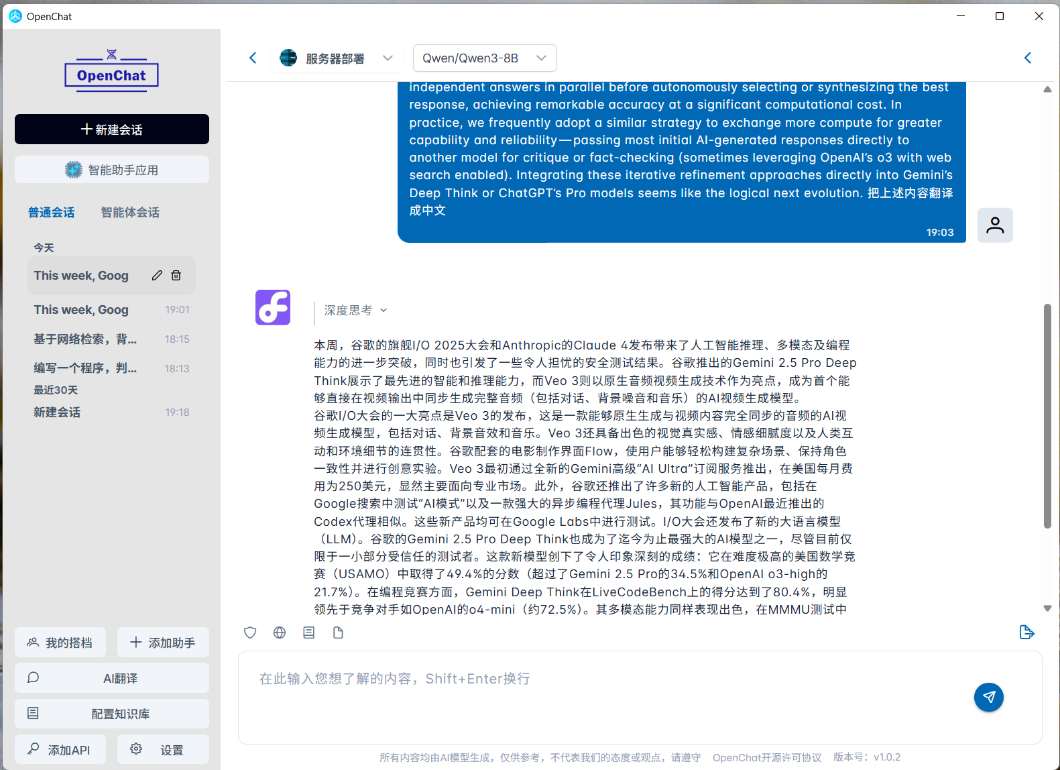

>> 基于本地客户端接入

基于OpenChat、ChatBox或CherryStudio等UI客户端,用户可以方便地访问在服务器上部署的DeepSeek 服务,并可以基于个人文档构建知识库和实现联网搜索等功能。

>> 基于浏览器接入大模型

元脑CPU推理服务器支持在部署 vllm 推理服务的同时,同步集成 Open WebUI 。Open WebUI是一款开源且可自托管的Web用户界面工具,专为本地或私有部署的大语言模型交互而设计。用户无需在本地安装客户端,即可通过Web界面便捷访问和使用大模型服务。

OpenStation已全面集成了Open WebUI,支持一键部署,并实现用户账号与模型服务的统一管理。平台功能涵盖系统配置、服务监控、模型管理和权限控制等方面。

有关具体操作方法,请参阅 OpenStation 官方指导文档

基于该部署指南,元脑CPU推理服务器NF8260G7和NF8480G7单台服务器即可高效运行DeepSeek-R1和Qwen3、QwQ等模型,实现单用户超过20 tokens/s的推理性能,并能同时处理20个并发用户请求,为更多互联网、金融、医疗行业用户,带来高效、稳定的DeepSeek等大模型部署方案,助力大模型快速落地应用。

欢迎下载CPU服务器部署大模型详细教程直接体验

元脑CPU服务器部署大模型更多技术交流

![]()

第八代服务器

第八代服务器 第七代服务器整机柜服务器高密度服务器

第七代服务器整机柜服务器高密度服务器 交换机

交换机 软件数据中心

软件数据中心 核心交换机

核心交换机 汇聚/接入交换机

汇聚/接入交换机 软件边缘网络

软件边缘网络 交换机

交换机 无线局域网

无线局域网 全光网络

全光网络 路由器

路由器 软件安全及运维

软件安全及运维 防火墙

防火墙 综合运维软件

综合运维软件